羲和能源大数据平台:全球气象、风光能源数据尽在掌握

【1】如何获取光伏发电项目申请报告

羲和能源大数据平台(羲和能源大数据平台 - 首页)自今年2月上线以后,用户数持续增长,目前已提供6万人次的数据服务。

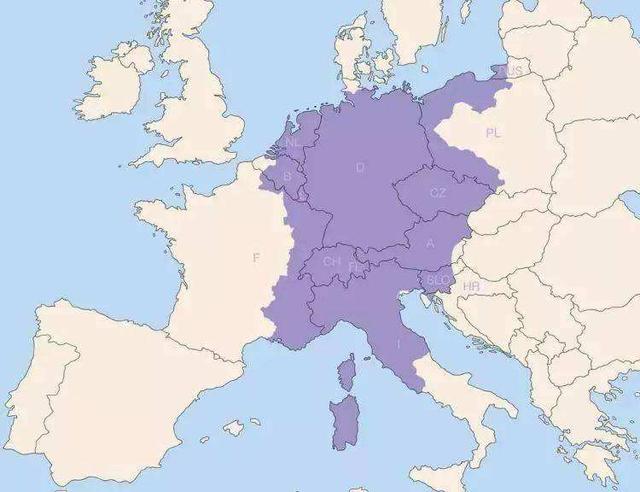

平台可提供1980年至今全球范围内超长时间和超高空间分辨率的风电光伏出力的时间序列、相配套的风速、辐照、气温等气象要素和人口、地表覆盖等地理空间数据,并建立了一套算法,提供风电、光伏小时级发电功率曲线模型,为实现“双碳”目标及新型电力系统分析、研究、预测等提供数据支撑。

随着用户逐渐增多,我们将推出系列文章,指导用户正确使用平台功能,获取所需的精准数据。本期,我们来谈谈如何获取光伏发电项目申请报告。

步骤:

1、确定地理位置。这是使用平台任何功能的第一步。

用户可以对经纬度、查询数据的起止时间进行设置(时区自动确定)

注意选择数据源:

历史数据数据源来源于欧洲中期天气预报中心、美国国家航空航天局和羲和平台数据;

预测数据主要来源于德国气象局和羲和平台数据。

2、打开光伏发电设置模块。

材料类型、装机容量、系统损耗、地形、太阳追踪、倾角和朝向是可自定义设置的基础参数。

平台可根据近10年历史数据,计算得出光伏最优倾斜角和朝向。

页面中,白色背景空格都可以根据用户需要全自定义或选择相应选项,灰底数据栏则根据其他数据自动测算得出。

例如,打开光伏发电系统设置,可进一步对光伏组件的供应商、组件类型、型号和逆变器供应商、型号、MPPT功能逐一按需设置,收益测算的几项参数可根据当地实际情况或用户理论数据进行设置。

设置好参数后,平台还可以帮助用户校核数据,之后一键生成。

3、下载数据

点击下载,扣除相应积分后,会自动生成光伏出力的曲线图,还能再下载获得CSV格式(可用EXCEL打开、编辑)的数据表格。

4、太阳能资源评估报告

用户可下载该报告,获取自定义模板说明,也可以自行上传模板。

综上,羲和能源大数据平台系统数据来源权威性强,数据准确度高。用户在操作过程中可享受“定制化”数据服务,获取完整、详细的数据材料。#光伏##气象数据下载#

找到了一个宝藏网站:kaggle.com,里面搜集了很多公开的dataset,什么F1赛事数据、世界人口数据、数据科学岗位薪资数据、印度2014-2020旅游业数据,CSV格式居多,正好拿来给我练习ELK的大数据分析功能。

fast-cpp-csv-parser是一个C++实现的CSV文件快速解析器,它只有一个头文件,小而易用。它之所以成为快速解析器是因为这个解析器的磁盘读取和CSV解析是分别使用自己的线程实现。

fast-cpp-csv-parser解析时还提供了转义字符串功能,你可以在编译时通过模板启用或禁用此功能,它会影响解析速度。如果没有使用转移字符串,那么就禁用,这样可以保证最快效率地执行解析。

fast-cpp-csv-parser能够自动处理Windows/Linux操作系统的换行符,而且对于UTF-8中的BOM也能够正确地忽略。

项目地址:网页链接

连续1个月敲代码结果,WIFI万用表测量值服务端不间断存储就要上线了!打开万用表,万用表的测量值会持续存储在服务端。

第一张动图展示的是查询任意时间段的历史数据,以曲线的形式展示出来。

第二张动图展示的是服务端可将历史数据存储成CSV格式发送到用户邮箱要。

WIFI万用表完全可以当做是一台在线监测记录电压,电流,电阻,电容测量值的仪器,这是与普通万用表本质的区别

一个人又搞硬件,又搞服务端,又搞数据库,有事还得帮我老婆解决小程序问题,精力不够用了!静下心来一步一个脚印的做出好产品吧!

华为/荣耀手机,负一屏支持导入课程表了。以下是新版的导入方法,上学的小伙伴可以尝试一下,大概原理是修改生成csv文件,然后保存刷新后就能够正常显示了。

注意,课程名称、周数节数、教室名称这3项为必填项。

今天收到一个客户的需求。他们本身有一个桌面软件,使用vc6开发的。vc6这种上古软件估计很多程序员都不知道了。软件的功能就是把二进制bin文件转化成csv文件,功能其实很简单。

目前的软件是单线程的,处理一个文件大约需要三分钟。客户想改成多线程的。其实这种读别人源码改造本来就很烦,并且还属于优化性质的,不一定做出来能达到效果。我就问客户预算多少,要是能有1000的话就接来试试。

结果客户说,300不少了吧,我登时傻眼了。这个价格,估计大学生都不会接。让客户自己去弄吧。

不要把自己的技术弄得太廉价。现在我接私活,先预估工作量,一天800左右,太低了宁愿休息,出去跑跑步锻炼身体比啥都好。

StarRocks-2.4 正式版发布

StarRocks是开源的新一代极速全场景MPP数据库。它采用新一代的弹性MPP架构,可以高效支持大数据量级的多维分析、实时分析、高并发分析等多种数据分析场景。StarRocks 性能出色,它采用了全面向量化技术,比同类产品平均快3-5倍。

新增特性

支持构建多表物化视图,实现多表 JOIN 查询加速。

支持通过 INSERT OVERWRITE 语句批量写入并覆盖数据。

[公测中] 提供无状态的计算节点(Compute Node,简称 CN 节点)。计算节点支持无状态扩缩容,您可通过 StarRocks Operator 部署,并基于 Kubernetes 管理容器化的计算节点,以此实现自动感知系统负载并水平扩展计算节点。

Outer Join 支持通过 <、<=、>、>=、<> 等比较操作符对多表进行非等值关联。

支持创建 Iceberg catalog 和 Hudi catalog,创建后即可查询 Apache Iceberg 和 Apache Hudi 数据。

支持查询 CSV 格式 Apache Hive™ 表中的 ARRAY 列。

支持通过 DESC 语句查看外部数据的表结构。

支持通过 GRANT 或 REVOKE 语句授予或撤销用户特定角色或 IMPERSONATE 权限,并支持通过 EXECUTE AS 语句使用 IMPERSONATE 权限执行当前会话。

支持 FQDN 访问:您可以用域名或结合主机名与端口的方式作为 FE 或 BE 节点的唯一标识,有效避免因 IP 变更导致无法访问的问题。

flink-connector-starrocks 支持主键模型 Partial Update。

函数相关:

新增 array_contains_all 函数,用于判断特定数组是否为另一数组的子集。

新增 percentile_cont 函数,用于通过线性插值法计算百分位数。

功能优化

主键模型支持持久化 VARCHAR 类型主键索引。自 2.4.0 版本起,主键模型的主键索引磁盘持久化模式和常驻内存模式支持相同的数据类型。

优化外表查询性能。

支持查询 Parquet 格式文件时延迟物化,提升小范围过滤场景下的数据湖查询性能。

查询数据湖时,支持通过合并小型 I/O 以降低存储系统的访问延迟,进而提升外表查询性能。

优化窗口函数性能。

Cross Join 支持谓词下推,性能提升。

统计信息支持直方图,并进一步完善全量统计信息采集。

支持 Tablet 自适应多线程 Scan,降低 Scan 性能对同磁盘 Tablet 数量的依赖,从而可以简化对分桶数量的设定。

支持查询 Apache Hive 中的压缩文本(.txt)文件。

调整了计算默认 PageCache Size 和一致性校验内存的方法,避免多实例部署时的 OOM 问题。

去除数据导入主键模型时的 final_merge 操作,主键模型大数据量单批次导入性能提升至两倍。

支持 Stream Load 事务接口:支持和 Apache Flink®、Apache Kafka® 等其他系统之间实现跨系统的两阶段提交,并提升高并发 Stream Load 导入场景下的性能。

函数相关:

COUNT DISTINCT 支持多个字段,可计算多字段组合去重后的结果数目。

窗口函数 max 和 min 支持滑动窗口。

优化函数 window_funnel 性能。

我一般都推荐用csv格式返回,一个是表头一个是表体。更精简,更轻量,分页也更方便。

互联网架构小马哥面试官:有一个 List 对象集合,如何优雅地返回给前端?我懵了

voici.js是一个能让你在终端界面制作图表的开源库

1.支持文本行和列显示样式

2.支持列大小调整

3.支持汇总功能

4.支持动态列调整功能

5.支持JSON和CSV文件导入功能

6.支持表格导出为PNG和TXT格式文件

7.支持排序功能

项目地址:网页链接

tablesgenerator.com 是一个在线表格生成工具,它以优雅的方式设计表格模型、填充数据。支持五种表格格式:LaTex、HTML、Text、Markdown、MediaWiki。只要点击Generate按钮,即刻得到结果。当然,你也可以用已有的表格数据比如CSV来进行格式间转换。

数据挖掘技术,是指从大量的、不完全的、有噪声的、随机的实际应用数据中,提取隐含在其中的、人们事先不知道的、但又是潜在有用的信息和知识的过程。机器学习技术是数据挖掘中非常有用的工具之一,新西兰怀卡大学开发的Weka机器学习软件Weka汇集了当今主要的数据挖掘算法和数据预处理工具:回归、分类、聚类、关联规则挖掘以及属性选择。Weka的主要图形用户界面Explorer,在Explorer窗口顶部六个标签的功能分别是:1)预处理(Preprocess):选择数据集,并以多种方式对其进行修改。2)分类(Classify):训练用作分类或回归的学习方案,并对它们做评估。3)聚类(Cluster):学习数据集的聚类。4)关联(Associate):学习数据的关联规则并对其评估。5)选择属性(Selectattributes):在数据集中选择最相关的部分。6)可视化(Visualize):查看不同的二维数据点图并与其互动。数据准备主要包含以下三个方面:

1)了解数据挖掘需要处理的任务,并制定一个针对数据挖掘结果的评价标准。这个项目目标应该是适用于选取的聚类分析方法来达到的。

2)根据挖掘项目的目标,确定项目涉及的业务对象,确定要进行挖掘所需要的数据源。

3)将多个数据源中的多种数据整合在一起,数据集成的目的是解决语义模糊性,统一数据格式,消除冗余,保证数据的一致性、完整性和有效性,为数据挖掘打下良好的基础。

Weka存储数据的原始方式是ARFF格式,大多数电子表及数据库程序允许用户将数据导入CSV格式的文件中,Weka能够直接读取CSV数据表。数据源主要有客户档案记录、客户营销记录、销售单主表、销售退货表、客户联系表、客户投诉记录等,数据集成后生成客户行为特征表电子表格customerbehavior.xls,在Microsoft Excel中将此文件存储为cus⁃tomerbehavior.csv,Explorer能够直接读取CSV电子数据表格。将此数据集通过Weka的图形用户界面Explorer载入系统,供下面的数据挖掘使用。单击“Explorer”按钮,进入“Explorer”界面。单击“Preprocess”标签,进入预处理阶段。单击“Open file”按钮,通过弹出的对话框选择数据文件customerbehavior.csv,在这里假定数据文件中的数据是完整的、无噪声的、一致的。载入数据文件后,面板中会显示所载入的数据集包含的实例个数和属性项数。所载入的数据集含有14个实例和12个属性。这里选custompackage作为分类属性。可通过单击复选框和Remove按钮来删除属性。单击All则选中全部属性,None表示不选,Invert则反向转换目前的选择。通过点击Undo按钮撤销所做的改动。点击Edit按钮会弹出一个编辑器。通过编辑器可检查数据,搜索具体的值并对其进行编辑,以及删除实例和属性。

创建决策树的问题可以用递归形式表示。首先,选择一个属性放置在根节点,为每一个可能的属性值产生一个分支。这将使样本集分裂成多个子集,一个子集对应于一个属性集。选择CustomPackage属性作为根节点,运用Weka平台的“Explorer”,实施基于决策树技术的客户群体分类的客户模型的建立。单击WekaExplorer窗口中的Classify标签。查看结果。在该结果的开头给出了数据集概要并注明所用的评估方法是10-foldcross-validation,该方法是默认的。实验选用的是J48分类器。#科研软件# #能源化工装置运行数据挖掘技术# #开源软件#

【JDBC 在性能测试中的应用】我们能否绕开 http 协议,直接测试数据库的性能?是否觉得从数据库中导出 CSV 文件来构造压测数据很麻烦?怎样在压测结束后做数据清理?能不能通过数据库中的插入(删除)记录对压测请求做断言?使用阿里云性能测试工具 PTS 可以轻松解决上述问题。JDBC 在性能测试中的应用-阿里云开发者社区

#沈阳头条#辽宁省实施省级统筹后,从9月份开始,不少单位出现了养老账户无法做实的问题,可能会影响职工退休办理等。这是因为系统升级后,沈阳市用人单位的编码和职工编码前面添加了“21010”,如果报盘软件未升级,按原来的格式报盘,就不能正确做实账户。

新的报盘格式为:单位编码,人员编码、姓名、身份证号、缴费基数、缴费月份和缴费额,字段之间用逗号分割。比如:210100453548,2101040268378,李某某,21020419660509429X,15714,202010,1257.12。如何制作呢?

1.先将原来的数据保存到电子表格中,制作成对应的表格,如图1

2.将电子表格另存为csv格式。并经文件的扩展名字改为txt,这样报盘文件就做好了,上报社报中心就能做实账户了。

JavaScript的新锐之秀Deno发布了1.26版本,最近几个版本一直致力于性能提升,这次的版本同样聚焦于性能瓶颈问题:一是减少尽可能多的延迟,另一个方面是处理过大的开销。

第一个性能提升是TextEncoder。对于小的载荷,其吞吐量可达到原来的5倍,对于大的载荷,其吞吐量可达30倍。

第二项性能提升是写文件。对于小文件,同步写文件操作是原来的1.44倍;异步写文件操作是原来的1.15倍。

第三项性能提升是CSV格式文件解析。虽然整个项目做了大量的解析优化工作,但目前的这个版本提升并不是很明显,在macOS上解析速度是之前的1.36倍,在Linux上解析速度是之前的1.19倍,后续版本还有很大的提升空间。

还有其它的好几项优化,详见官方博客:网页链接

#头条创作挑战赛#

说来搞笑,我学vue是因为这个原因!

36岁的时候,接手了一个项目,需要用到采集器。一开始用的是火车头。为了进一步提升效率,我们需要把火车头采集到的数据转化为另外一种csv格式(即排版),于是就需要人工来做这个事情。

虽然比较耗时间,但也能勉强搞定。后来我们语言采集其它数据源,发现火车头采集数据不完整。当时公司是有程序员的,只是程序员属于公共支持部门,每次提一个需求都需要排期,等很久。还有就是是,做出来的东西总和想要的有所差别,需要几轮拉锯战才能得到勉强可用的功能。实在受不了这种低效率,于是就萌生了做编程的念头。

我是从python开始学的,入门很顺利,自学两周就做了一个简陋版本的采集器,满足了采集需求。后来用代码实现了数据转化功能,大幅度提高部门工作效率。随着数据量的增加,人员也开始增加,我需要把数据展示给部门的同事。朋友就推荐我学vue。

上网一看,发现vue的用户很多,口碑也不错,更重要的是,大家都说vue简单!结果悲剧了,感觉这东西比python的django,go的gin难多了,各种依赖一大堆!

重庆的医保查询系统维护大半年了都还没好。今天忙了近一整天,就一件事。

财务要求我们每个月都要提交员工的社保扣款明细。以前都是直接在社保网上导出数据就可以了,自从医保系统进入维护期后,医保这一项的数据就查不到了。今天听说可以从渝快办进入到医保局的公共服务平台去查询了,赶紧试试。没想到到处找不到入口,一会儿提示要以法人办事名义进入,一会儿要求下载重庆市政府APP,一会儿又让扫码下载电子营业执照……几番操作下来,这不行那不行,还是进不去。打电话咨询了社保局、医保局、税务局,都没有找到解决办法,社保工作人员说他们已经接到很多电话反应网上系统数据导不了以及导出来的数据不准确的问题,让我们直接带上介绍信去窗口拷贝数据。无奈之下,我们准备好了介绍信,打算明天乖乖去跑一趟。就在最后关头,人事小妹儿在旧的社保查询系统下发现了一个很小字体的链接网址,复制这个网址到浏览器后打开一看,又进入到了先前打开过的渝快办界面,奇怪的是,从这个界面进去以后就能进入到医保查询系统了。不过这当中还要经历注册什么的。再然后,我们找到了医保扣款明细,开心地导了出来。没想到意外又出现了!下载下来的表格是乱码!竟然是乱码!它竟然不是Excel文件,而是没有听说过的csv文件。啊??!!这是什么鬼!于是又寻求度娘的帮助,学习如何将csv文件转换成Excel文件……历经千转百回,终于得到了我们想要的数据。

我就想问问,网络办事到底是方便群众还是考验群众的智力眼力耐力呢?不知大家有遇到同样问题的吗?

[Windows] 强大的文本编辑器EmEditor Professional v20.5.4

今日破五 带来一款 强大的文本编辑器——EmEditor

mEditor– 号称世界上最快的文本编辑器!EmEditor 是一款快速,轻巧,可扩展,使用方便的 Windows 代码编辑器。支持宏,Unicode,代码段插件,还能处理大数据以及 CSV 文件,无需 Excel,堪称最强 CSV 编辑器。软件自带简体中文,支持32位和64位版。

关联Notepad++ Ultraedit win自带记事本

下载地址

Emurasoft EmEditor Professional 20.5.4 官方版 [2021/02/16]

64位便携版网页链接

64位安装版网页链接

32位便携版网页链接

32位安装版网页链接

Emurasoft EmEditor Professional 14.8.1 for Winddows XP

网页链接

网页链接

DMAZM-WHY52-AX222-ZQJXN-79JXH((亲测永久)

分享一个shell脚本处理文本的命令,假如我有两个文件a.txt, b.txt,我想要把a.txt文件中出现在b.txt文件中的内容,插入到b.txt文件中相同内容的后面,可以通过如下的命令实现 nl other_banks.txt |awk '{print "sed -i "s/"$2"/"$2","$2"/g" gwhome_banks.txt"}'|sh,至于用什么进行分割,大家可以随意,我是用英文的逗号分割,便于我保存为csv文件,通过excel进行处理。

不管是大公司的网管,还是做系统集成项目的技术支持

总会碰到网络割接,设备迁移的情况,你也搞不清楚

公司的网络体系和结构,也不知道网线的那一头,

究竟是接的打印机呢

还是路由器,偶然逛技术论坛

发现一个开源软件Advanced IP Scanner确实挺好用的,下面简单介绍一下:

+++

No.1-局域网扫描:可以自行设置扫描的网段,通常是C类办公网络

可以扫描局域网内所有入网设备,不管是打印机,服务器还是交换机

都能快速扫描出来,是否在线

扫描结束后还能把记录导出成CSV或者HTML网页格式

适合做成网络训练报告

+++

No.2-支持ping+ssh+远程桌面,轻度运维适用

+++

还有一个我最喜欢的功能

支持网路唤醒,

还能找到共享的文件夹