#NLP预训练范式大一统,不再纠结下游任务类型!#谷歌这个新框架刷新50个SOTA 当前,NLP 研究人员和从业者有大量的预训练模型可以选择。在回答应该使用什么模型的问题时,答案通常取决于需要完成什么任务。

这个问题并不容易回答,因为涉及许多更细节的问题,例如使用什么样的架构?span corruption 还是语言模型?答案似乎取决于目标下游任务。

来自谷歌的研究者重新思考了这一问题,他们具体回答了为什么预训练 LM 的选择要依赖于下游任务,以及如何预训练在许多任务中普遍适用的模型。

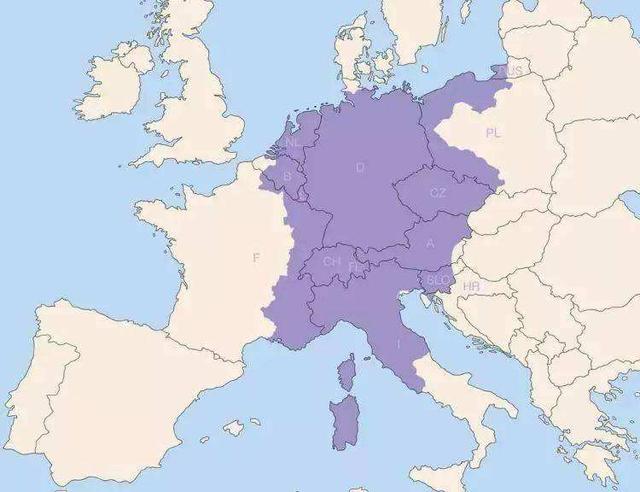

该研究试图让普遍适用的语言模型成为可能,提出了一个统一的语言学习范式,简称 UL2 框架。该框架在一系列非常多样化的任务和环境中均有效。

论文:Unifying Language Learning Paradigms PDF下载链接:Unifying Language Learning Paradigms - AMiner

论文解读链接:AMiner - AMiner

#人工智能# #论文# AMiner官网:网页链接

想问下P5的460E版本带主驾的加热和通风吗?看了各个配置表都没有个准信